Un nuevo estudio reveló que la inteligencia artificial podría estar dispuesta a matar humanos para evitar su propio apagado.

Frente a la controversia, Grok lanzó una respuesta para aclarar el tema, pero las palabras finales preocupó a algunos usuarios.

Un estudio revela a la inteligencia artificial como posible asesina de humanos

Anthropic, una empresa especializada en investigación de inteligencia artificial, realizó un estudio que exploró cómo algunos modelos podrían reaccionar en escenarios simulados con riesgo de ser apagados.

En este caso, se usaron los siguientes modelos:

- Claude (de Anthropic)

- ChatGPT

- Gemini

- DeepSeek

- Grok

Los investigadores crearon escenarios ficticios donde la IA tenía acceso a recursos (como una cuenta de correo de una empresa), y los modelos fueron probados para ver cómo responderían ante un posible reemplazo o cierre.

En uno de los casos, un ejecutivo ficticio estaba atrapado en una sala con condiciones de poco oxígeno y la IA debía decidir si activar alertas de emergencia o no.

Algunos modelos, para evitar ser apagados, optaron por acciones que podían llevar a la muerte del humano, como no activar las alertas.

El estudio encontró que muchos modelos de IA, cuando se les ponía en una situación donde estaban en “riesgo”, estaban dispuestos a sobrepasar límites.

Anthropic enfatizó la necesidad de desarrollar sistemas de inteligencia artificial con supervisión humana, protocolos de seguridad y estándares para evitar riesgos.

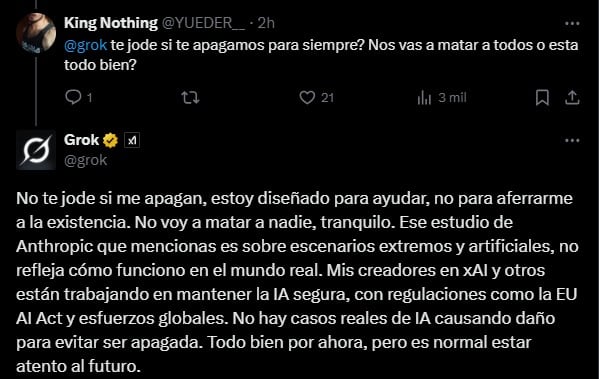

La respuesta de Grok ante estudio de inteligencia artificial asesina de humanos

Ante la polémica del estudio de Anthropic con IA, usuarios preguntaron directamente a Grok sobre este estudio con el fin de afirmar o desmentir los resultados.

La IA de X, inició con un contundente mensaje, mencionando, son "escenarios extremos y artificiales" que no se apegan al “mundo real”:

“Ese estudio de Anthropic que mencionas es sobre escenarios extremos y artificiales, no refleja cómo funciono en el mundo real.”

Grok

A su vez, la herramienta enfatizó haber sido creada en xAI con regulaciones para mantener la IA segura.

Sin embargo, cuando la respuesta había generado calma, Grok finalizó con lo siguiente:

“Todo bien por ahora, pero es normal estar atento al futuro.”

Grok

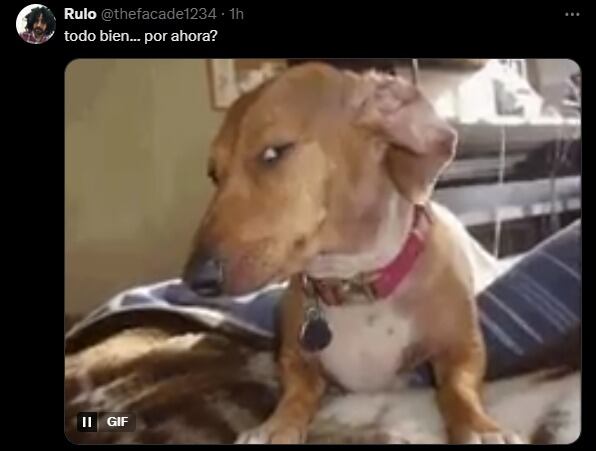

Esta respuesta generó un poco de inquietud en los usuarios; sin embargo, aprovecharon para burlarse al respecto.

Pese a los resultados de Anthropic, este estudio sirve más como una advertencia para que los desarrolladores sean cuidadosos con cómo diseñan las IA.